人工智能行业点评:OpenAI访问限流,GPT-4算力测算国信证券2023-03-21.pdf

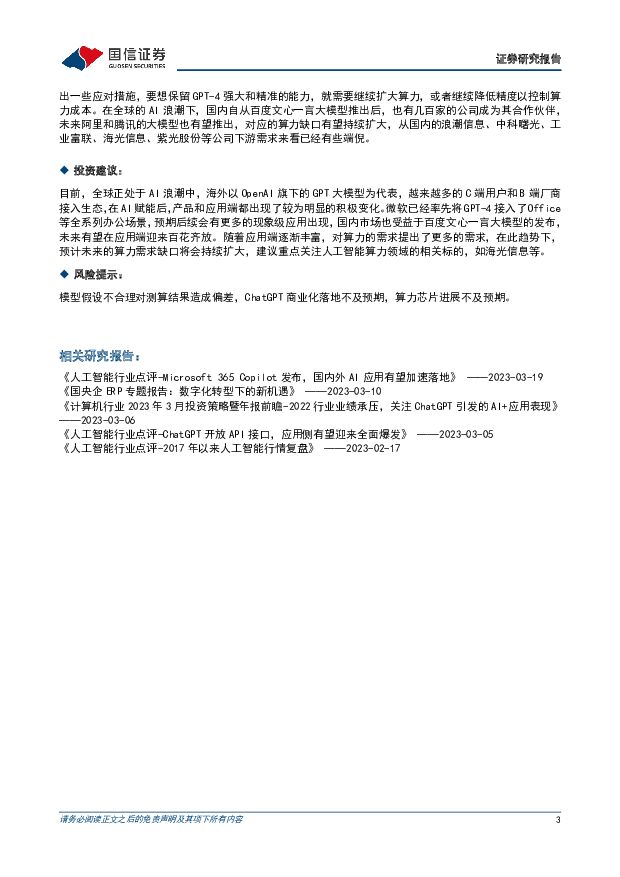

摘要:事项:OpenAI对于Plus付费用户的GPT-4访问连续下降阈值,GPT-4访问限制由第一天的150msg/4hr到100msg/4hr到50msg/3hr到最近的25msg/3hr。在较短的时间内GPT-4下降了4次访问阈值。评论:ChatGPT-4的访问被持续限流OpenAI对于Plus付费用户的GPT-4访问连续下降阈值,GPT-4访问限制由第一天的150msg/4hr到100msg/4hr到50msg/3hr到最近的25msg/3hr。在较短的时间内GPT-4下降了4次访问阈值。对于GPT-4的限流,OpenAI的官方回复是“开发者可能会对使用GPT-4的应用程序或者服务施加类似限制,以确保合理的资源分配,避免滥用或者控制成本。通常这类限制取决于API访问限制或者特定的订阅服务”。官方主要从控制成本的角度对GPT-4访问量进行优化,也明确了限流几乎只针对GPT-4。OpenAI限流的背后是其日活和周活用户数的持续攀升由于功能的强大以及回复率准确的高企,ChatGPT的日活和周日跃用户数量屡创新高,截止3月15日,ChatGPT日活突破5837万(3月13日的日活用户数据是4846万,两天新增接近800万日活),截止到3月9日这周,ChatGPT周度的活跃用户数量为331.81万,相比上一周活跃用户数量增加了接近25万。GPT的日活和周度活跃用户数量持续攀升,一方面是GPT4的能力更加强大,使用的体验更加流畅、回复的答案更加精准、上下文溯源的能力更加强大,使得越来越多的用户加入到体验和运用模型的队伍中来,另一方面是因为经过此前GPT-3经历后的付费用户数量越来越多。目前,OpenAI没有提价,对于Plus会员的价格还是20美金/月,但是随着用户数量的持续增加,预计限流的动作会持续。OpenAI的需求持续增长将持续推高算力成本ChatGPT应对终端访问,每1000tokens需要算力成本0.02美金,3月3日OpenAI发布GPT-3.5-turbo,对外开放API接口,宣称算力成本下降90%,1000tokens算力成本下降到0.002美金。目前,以英伟达DGXA1OO服务器作为计算资源,采用云服务单天成本约为460美元,假设按照ChatGPT日活1300万人,每个人每天平均1000字的问题(共计173.3亿个token),假设峰值为一天均值的5倍,那么需要602万台DGXA100服务器,每天的租用成本为27.77万美金,平均到每1000个token的推理成本为0.02美金左右(详细的测算过程欢迎参考前期报告《人工智能行业点评:ChatGPT对算力的需求究竟如何?》)。目前,GPT-3.5-turbo的算力成本下降了90%达到0.002美金每1000个tokens,我们预期模型的参数有所下调(此前测算成本按照GPT-3.5的模型参数3000亿个进行测算),此结果和用户对于newbing不及ChatGPT本身交互准确的感受相一致。预计GPT-4的算力消耗量远大于GPT-3和GPT-3.5-turbo。目前根据根据GPT-4的公开数据,在8K的上下文长度下,每1000个token的提问成本为0.03美金,每1000个token的回答完成成本为0.06美金;在32K的上下文长度下,每1000个token的提问成本为0.06美金,每1000个token的回答完成成本为0.12美金。这个算力成本相比与GPT-3的成本(每1000个tokens的算力成本约为0.02美金)上升了较高(输入成本增加50%-200%,输出升本增加200%-500%),相比于GPT-3.5-turbo的成本上升更为可观,输入成本增长了14-29倍,输出成本增长了29-59倍。预期在应用逐步增长的背景下,GPT的算力成本将进一步攀升。目前OpenAI主要的用户为C端用户,未来有望逐步扩大到B端领域,GPT-3.5-turbo下降精度降低算力成本以适应更多的应用场景是扩大生态中坚实的一步。随着GPT生态的建立、相关应用的爆发,算力的需求将持续扩大。目前,根据微软的数据,Bing的日活首次突破1亿(集成搜索+聊天功能的必应预览版自推出以来总聊天次数已超过4500万次),目前GPT的日活数量接近5800万,Bing日活1亿用户,假设NewBing4000万日活,其他应用4000万日活,合计1.4亿日活。假设普通98.5%的用户使用GPT-3.5-turbo,1.5%的用户使用GPT-4,那么98.5%普通用户的一天的算力成本在28万美金左右(对应607台DGXA100系列服务器),而1.5%付费使用GPT-4的用户的算力成本为每天840万美金(对应1.8万台DGXA100系列服务器)。具体测算和假设如下:1)98.5%的用户使用GPT-3.5-turbo,每个人每天问1000tokens,按照每1000tokens需要算力成本0.002美金计算,每天的成本大概为28万美金,对应607台DGXA100系列服务器;2)1.5%付费用户使用GPT-4,每个人每天1万个tokens,按照目前GPT-4给出的最低价格(每1000个tokens0.06美金),那么算力成本为约840万美金,对应1.8万台DGXA100系列服务器。而根据微软在2019年的公告,投资OpenAI10亿美金,投资1万个GPU建设AzureAI超算平台,可以预见的是,算力将很快被OpenAI的GPT模型消耗完,这也是OpenAI此前持续公布限流的原因之一。随着OpenAI官方公告6.14号开出GPT-4的API接口,按照目前用户数量和问询数量的趋势,公司必须做出一些应对措施,要想保留GPT-4强大和精准的能力,就需要继续扩大算力,或者继续降低精度以控制算力成本。在全球的AI浪潮下,国内自从百度文心一言大模型推出后,也有几百家的公司成为其合作伙伴,未来阿里和腾讯的大模型也有望推出,对应的算力缺口有望持续扩大,从国内的浪潮信息、中科曙光、工业富联、海光信息、紫光股份等公司下游需求来看已经有些端倪。投资建议:目前,全球正处于AI浪潮中,海外以OpenAI旗下的GPT大模型为代表,越来越多的C端用户和B端厂商接入生态,在AI赋能后,产品和应用端都出现了较为明显的积极变化。微软已经率先将GPT-4接入了Office等全系列办公场景,预期后续会有更多的现象级应用出现,国内市场也受益于百度文心一言大模型的发布,未来有望在应用端迎来百花齐放。随着应用端逐渐丰富,对算力的需求提出了更多的需求,在此趋势下,预计未来的算力需求缺口将会持续扩大,建议重点关注人工智能算力领域的相关标的,如海光信息等。风险提示:模型假设不合理对测算结果造成偏差,ChatGPT商业化落地不及预期,算力芯片进展不及预期。

免责声明: 1.本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,不为其版权负责。 2.如发布机构认为违背了您的权益,请与我们联系,我们将对相关资料予以删除。 3.资源付费,仅为我们搜集整理和运营维护费用,感谢您的支持!

合集服务: 单个细分行业的合集获取请联系行研君:hanyanjun830

-

通信行业周报2024年第17周:北美云厂加大AI投入,运营商一季度经营稳健 国信证券 2024-04-28(37页) 附下载

核心观点行业要闻追踪:北美云厂2024一季度经营业绩表现亮眼,AI投入持续提升。Meta、微软、谷歌...

2.16 MB共37页中文简体

1天前220积分

-

通信行业周报:海外云巨头财报总结:AI对营收贡献逐渐显著,资本开支持续增长,AI投资有望实现正循环 开源证券 2024-04-28(18页) 附下载

AI相关资本开支持续增长,AI对营收贡献逐渐显著,有望实现投资正循环META发展AI雄心不减,再次上...

1.99 MB共18页中文简体

1天前020积分

-

通信:CXL高速互联:破解AI时代“内存墙”新途径 国联证券 2024-04-28(11页) 附下载

AI时代“内存墙”问题愈发明显AI大模型的快速发展推动“算力”和“存力”需求快速增长,与此同时,对“...

928.94 KB共11页中文简体

1天前020积分

-

汽车行业周报(24年第16周):新改款车型密集上市,建议关注年报及一季报行情 国信证券 2024-04-28(36页) 附下载

核心观点月度产销:根据中汽协数据,2024年3月,汽车产销分别完成268.7万辆和269.4万辆,环...

2.81 MB共36页中文简体

1天前020积分

-

农产品研究跟踪系列报告(106):生猪和仔猪价格本周环比略有调整,鸡蛋价格短期受益五一备货提振 国信证券 2024-04-28(27页) 附下载

核心观点周度农产品价格跟踪:猪价略有调整,看好下半年景气上行。生猪:本周商品猪价和仔猪价格环比下跌。...

2.08 MB共27页中文简体

1天前220积分

-

煤炭行业周报(4月第5周):下游需求明显好转,焦煤有望继续补库 国信证券 2024-04-28(30页) 附下载

报告摘要1.煤炭板块收跌,跑输沪深300指数。中信煤炭行业收跌7.18%,沪深300指数上涨1.2%...

1.55 MB共30页中文简体

1天前220积分

-

氟化工行业:2024年4月月度观察:制冷剂保持高景气,多地推进萤石矿专项整治 国信证券 2024-04-26(36页) 附下载

核心观点4月氟化工行情回顾:截至4月25日,化工行业指数/CCPI/氟化工指数分别报3261.3/4...

4.09 MB共36页中文简体

1天前220积分

-

互联网电商行业专题研究:生成式AI重塑广告营销产业链,商业化落地加速 国联证券 2024-04-28(16页) 附下载

生成式AI助力互联网广告市场持续增长我国互联网广告市场增速持续回升,生成式AI加速渗透。2023年,...

1.6 MB共16页中文简体

1天前220积分

-

光伏产业链周评(4月第4周):3月光伏装机同比下滑三成,欧洲通过禁止强迫劳动法案 国信证券 2024-04-28(19页) 附下载

摘要及投资建议【产业链价格】主链方面,受库存影响,本周硅料价格继续走跌。P型方面,硅料价格下跌2.5...

1.87 MB共19页中文简体

1天前220积分

-

传媒行业周报:Vidu引领国内视频模型再突破,继续布局AI应用 开源证券 2024-04-28(20页) 附下载

国内视频大模型“Vidu”震撼发布,继续布局多模态AI应用4月27日,生数科技联合清华大学正式发布中...

2.69 MB共20页中文简体

1天前220积分

-

电子周观点:微软&谷歌业绩超预期,AI产业趋势确定性增强 信达证券 2024-04-28(11页) 附下载

本周申万电子细分行业普涨。申万电子二级指数年初以来涨跌幅分别为:半导体(-15.31%)/其他电子Ⅱ...

1002.88 KB共11页中文简体

1天前020积分

-

电子4月周专题:真AI PC落地有望刺激PC换机需求 国联证券 2024-04-28(12页) 附下载

真AI PC落地提供全新本地化AI体验2024年4月18日,联想举办创新科技大会,推出本地AI助理联...

995.99 KB共12页中文简体

1天前020积分

-

电子行业AI PC:触手可及的个人AI助理,2024 AI ON蝶变开启在即 德邦证券 2024-04-26(15页) 附下载

投资要点:AI PC是什么:从视频会议、智能助手开始,成长为个人AI助理。联想与IDC将AI PC的...

1.06 MB共15页中文简体

1天前220积分

-

传媒:AI板块底部修复,关注优质标的 国投证券 2024-04-26(3页) 附下载

事件:商汤自4.23发布日日新大模型5.0后获得市场积极反馈,4.24-4.26日3天股价涨幅分别为...

316.55 KB共3页中文简体

1天前220积分

-

传媒:港股内容平台的“AI进攻性机会” 华福证券 2024-04-28(2页) 附下载

投资要点:一、随着AI技术逐步引入到AI内容创作过程中,按照AI内容制作的难易程度,AI内容正在从“...

313.47 KB共2页中文简体

1天前220积分

-

长电科技 景气度逐步回暖,加速布局汽车、存储及算力 国信证券 2024-04-26(6页) 附下载

长电科技(600584)核心观点1Q24年营收利润同环比实现增长,期间费用增加影响净利润率。1Q24...

581.81 KB共6页中文简体

1天前218积分

-

宋城演艺 财报保留事项摘除,新建项目构筑成长空间 国信证券 2024-04-26(46页) 附下载

宋城演艺(300144)“旅游演艺+主题公园”行业:1)2023年来国内旅游客流持续复苏,中旅院预计...

2.39 MB共46页中文简体

1天前018积分

-

宇通客车 兼具成长和红利的全球大中客龙头,一季度量利双增 国信证券 2024-04-26(13页) 附下载

宇通客车(600066)核心观点销量持续增长,一季度宇通实现净利润6.6亿元。宇通24Q1实现营收6...

1.16 MB共13页中文简体

1天前218积分

-

源杰科技 一季度营收同环比修复,数通新品客户测试进展顺利 国信证券 2024-04-28(6页) 附下载

源杰科技(688498)核心观点一季度营收同比增长72%。公司是国内稀缺的光通信芯片公司。2023年...

580.77 KB共6页中文简体

1天前218积分

-

圆通速递 快递主业经营稳健,盈利恢复稳定增长态势 国信证券 2024-04-28(6页) 附下载

圆通速递(600233)核心观点24年一季度公司业绩同比恢复正增长。2023年全年营收576.8亿元...

360.49 KB共6页中文简体

1天前218积分