电子行业周报:AI芯片推陈出新,HBM或迎成长机遇华福证券2023-11-20.pdf

摘要:Nvidia 发布新一代 GPU 芯片 H200,HBM3e 助力性能升级。11 月 13 日,NVIDIA 宣布推出新一代的 GPU H200,本次新品发布的最大亮点在于,H200 为全球首款搭载 HBM3e 内存的 GPU。在全球最快内存 HBM3e 的助力下,H200 在内存容量、带宽和性能等方面迎来了全面升级。一方面,H200 能以每秒 4.8TB 的速度提供 141GB 内存,内存较 A100 和 H100 几乎翻倍,带宽较 A100 和 H100 分别增加 2.4/1.4 倍;另一方面,高内存带宽也使 H200 能够实现更快的数据传输,对于模拟、人工智能等内存密集型的高性能计算场景,H200 可实现较 CPU 快 110 倍的生成结果时间,为处理生成 AI 和 HPC 工作负载的海量数据提供强大支持。AI 高算力需求推动下,HBM 将大放异彩。AI 大模型的兴起催生了海量算力需求,而数据处理量和传输速率大幅提升使 AI 服务器对芯片内存容量和传输带宽提出了更高的要求。HBM 在此背景下应运而生。与传统DDR 存储器不同,HBM 使用 TSV 和微凸块垂直堆叠多个 DRAM 芯片,并通过封装基板内的硅中介层与 GPU 直接相连,从而具备高带宽、高容量、低延时与低功耗等优势,相同功耗下其带宽是 DDR5 的三倍以上。因此,HBM 突破了内存瓶颈,成为当前 AI GPU 存储单元的理想方案和关键部件。TrendForce 认为,高端 AI 服务器 GPU 搭载 HBM 芯片已成主流,2023 年全球搭载 HBM 总容量将达 2.9 亿 GB,同比增长近 60%,SK 海力士预测,HBM 市场到 2027 年将出现 82%的复合年增长率。HBM 成为存储大厂兵家必争之地,H200 或将再次掀起 HBM 布局大战。作为 AI 芯片的主流解决方案,HBM 受到了存储巨头的高度重视。自2013 年 SK 海力士首次成功研发 HBM 以来,三星、美光等存储巨头也纷纷入局,展开了 HBM 的升级竞赛,目前 HBM 已从第一代(HBM)升级至第四代(HBM3)。据报道显示,三星正在向 AMD 提供 HBM3 和交钥匙封装服务,并完成了与主要客户关于 2024 年 HBM 供应的谈判;SK 海力士则于今年 8 月向 Nvidia 提供了 HBM3e 的样品,并正在向 AMD 供应HBM3。与此同时,台积电也宣布将 CoWoS 产能扩大两倍,以期更好地支撑水涨船高的 HBM 需求。展望未来,H200 的推出有望再次掀起 HBM布局浪潮,随着存储巨头的持续发力,产业链上下游企业也将紧密部署,HBM 的影响力将逐步扩大并带来全新机遇。投资建议:半导体方向,建议关注上游设备、材料、零部件国产替代机会,如昌红科技、新莱应材、正帆科技、汉钟精机、腾景科技、英杰电气等,以及IC封装领域重点公司,如长电科技、通富微电、华天科技、晶方科技等;PCB方向,建议关注积极参与AI及服务器相关赛道的公司,如沪电股份、胜宏科技等;消费电子方向,建议关注消费电子行业的触底复苏机会,如顺络电子、风华高科、飞荣达、汇顶科技、春秋电子等。风险提示:地缘政治风险,电子行业景气复苏不及预期,消费电子下游需求不及预期,AI芯片下游需求不及预期,相关公司新产品研发不及预期,半导体国产替代进度不及预期

免责声明: 1.本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,不为其版权负责。 2.如发布机构认为违背了您的权益,请与我们联系,我们将对相关资料予以删除。 3.资源付费,仅为我们搜集整理和运营维护费用,感谢您的支持!

合集服务: 单个细分行业的合集获取请联系行研君:hanyanjun830

-

煤炭行业周报:备煤和非电需求集中释放,焦炭第五轮提涨搁置 华福证券 2024-05-12(16页) 附下载

投资要点:投资策略:动力煤方面1、产地方面,产地安全检查较严格,产量维持相对较低水平,产地市场相对活...

7.96 MB共16页中文简体

1天前39420积分

-

钢铁行业周报:钢厂保持复产,关注淡季消费表现 华福证券 2024-05-12(18页) 附下载

投资要点:投资策略:本周钢厂延续复产,高炉开工率周环比提升0.9个百分点,电炉开工率周环比下降0.8...

6.94 MB共18页中文简体

1天前21520积分

-

机床行业研究:从“04专项”复盘展望AI时代的机床产业政策 国金证券 2024-05-11(31页) 附下载

投资逻辑复盘:“04专项”政策目标为核心技术国产化突破,奠定国产替代基础什么是“04专项”:《国家中...

4.78 MB共31页中文简体

1天前77020积分

-

医药生物行业:继续坚定看多医药,关注鼓励新生人口方向 华福证券 2024-05-12(15页) 附下载

投资要点:行情回顾:本周(5.6-5.10)中信医药生物板块指数上升2.7%,跑赢沪深300指数1....

1.98 MB共15页中文简体

1天前45620积分

-

有色金属行业周报:美失业数据超预期,有色板块回调接近尾声,继续推荐金铜铝锑 华福证券 2024-05-12(16页) 附下载

投资要点:贵金属:美失业数据超预期,黄金价格上涨。本周贵金属价格先震荡后冲高,沪金重返560元/克以...

1.72 MB共16页中文简体

1天前18520积分

-

好音质白皮书:大师音质Cleer ARC 3开放式AI耳机 沙利文公司 2024-05-12(48页) 附下载

1什么是好音质?好音质需在清晰度、动态范围、自然真实感、低底噪和高清解码几个维度实现均衡,获得声学专...

3.36 MB共48页中文简体

1天前67620积分

-

通信行业周报:海外光模块企业数通产品快速发展印证光模块高景气度,重视AI时代光模块产业机遇 开源证券 2024-05-12(18页) 附下载

Coherent数通业务快速增长,积极布局多技术板块近日,Coherent发布了截至2024年3月3...

1.87 MB共18页中文简体

1天前34520积分

-

消费电子年报季报总结:苹果承压安卓弱复苏,看好二季度周期品价格提升 天风证券 2024-05-11(20页) 附下载

消费电子终端23Q4&24Q1销量情况:1)智能手机:苹果24Q1增速承压,安卓延续复苏势头;2)平...

1.26 MB共20页中文简体

1天前52520积分

-

电子行业周报:第一季度全球平板电脑市场恢复增长 华安证券 2024-05-12(14页) 附下载

主要观点:本周行情回顾从指数表现来看,本周(2024-05-06至2024-05-10),上证指数周...

2.65 MB共14页中文简体

1天前55220积分

-

计算机周报:终端AI与国产化“东风”:华为鸿蒙与国产算力全面崛起 民生证券 2024-05-12(17页) 附下载

本周(5.6-5.10)本周沪深300指数上涨1.72%,中小板指数上涨1.55%,创业板指数上涨1...

1.35 MB共17页中文简体

1天前37020积分

-

电子行业周报:AI达成协议,22家中国量子机构被列入实体清单 华鑫证券 2024-05-12(40页) 附下载

投资要点上周回顾跨行业比较,5月6日-5月10日当周,申万一级行业一半处于上涨状态。其中电子行业下降...

1.72 MB共40页中文简体

1天前46620积分

-

传媒行业周报:以AI为支点看中外企业如何发力? 华鑫证券 2024-05-12(20页) 附下载

投资要点本周观点更新2024年5月,二季度的承上启下月,2024年余下两季度也是企业在迎新国九条前主...

1.57 MB共20页中文简体

1天前91520积分

-

传媒互联网行业周报:Kimi+、DeepSeek-V2、OpenAI更新,持续关注AI产业推进 民生证券 2024-05-12(16页) 附下载

本周观点:Kimi发布新版本上线Kimi+,DeepSeek AI发布DeepSeek-V2,Ope...

1.39 MB共16页中文简体

1天前17520积分

-

房地产行业周报:城市更新积极推动,杭州、西安全面取消限购 华福证券 2024-05-12(12页) 附下载

周度观点:两部委联合发文推动城市更新示范工作5月6日,财政部办公厅、住房城乡建设部办公厅联合发布《关...

1.27 MB共12页中文简体

1天前97720积分

-

计算机行业周报:周观点:AI行业催化不断,坚定看好产业大势 开源证券 2024-05-12(8页) 附下载

市场回顾:本周(2024.5.6-2024.5.10),沪深300指数上涨1.72%,计算机指数下滑...

801.21 KB共8页中文简体

1天前25520积分

-

电子周观点:苹果新机或搭载ChatGPT,OpenAI下周推出部分更新 信达证券 2024-05-12(12页) 附下载

本期内容提要:本周申万电子细分行业多数下跌。申万电子二级指数年初以来涨跌幅分别为:半导体(-14.4...

1.22 MB共12页中文简体

1天前40020积分

-

电子行业周报 太平洋 2024-05-12(11页) 附下载

一、重点公司公告【普冉股份】公司股东杭州早月、杭州晓月、嘉兴得月计划根据市场情况通过集中竞价或大宗交...

1010.04 KB共11页中文简体

1天前46020积分

-

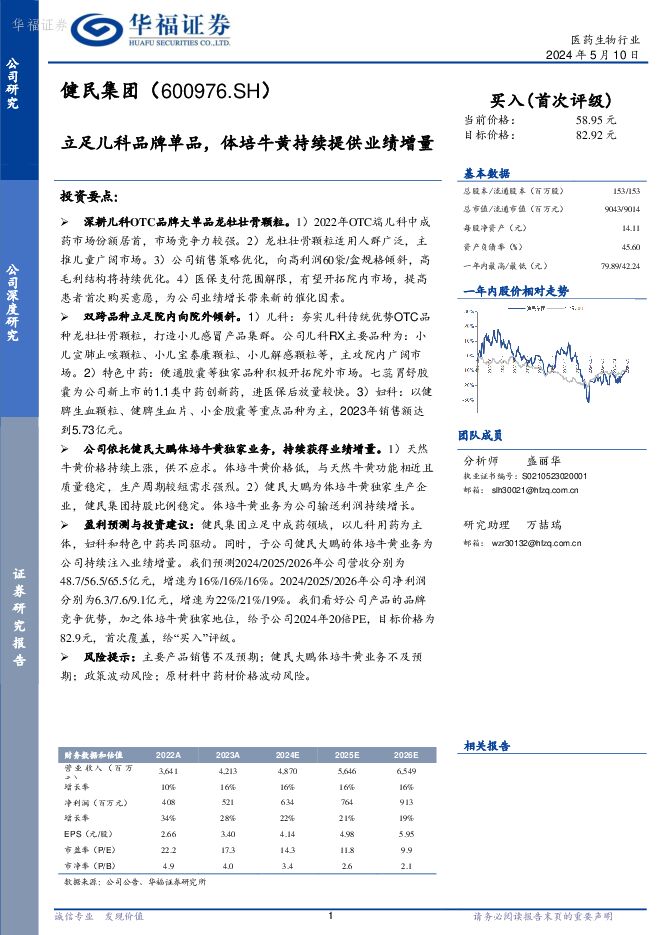

健民集团 立足儿科品牌单品,体培牛黄持续提供业绩增量 华福证券 2024-05-11(34页) 附下载

健民集团(600976)投资要点:深耕儿科OTC品牌大单品龙牡壮骨颗粒。1)2022年OTC端儿科中...

4.48 MB共34页中文简体

1天前82218积分

-

中文在线 数字文化开创者代表,AI赋能IP生态持续拓展 中泰证券 2024-05-12(25页) 附下载

中文在线(300364)公司概要:数字文化内容开创者代表,多元挖掘IP价值。中文在线随着以AI为前沿...

2.09 MB共25页中文简体

1天前29118积分

-

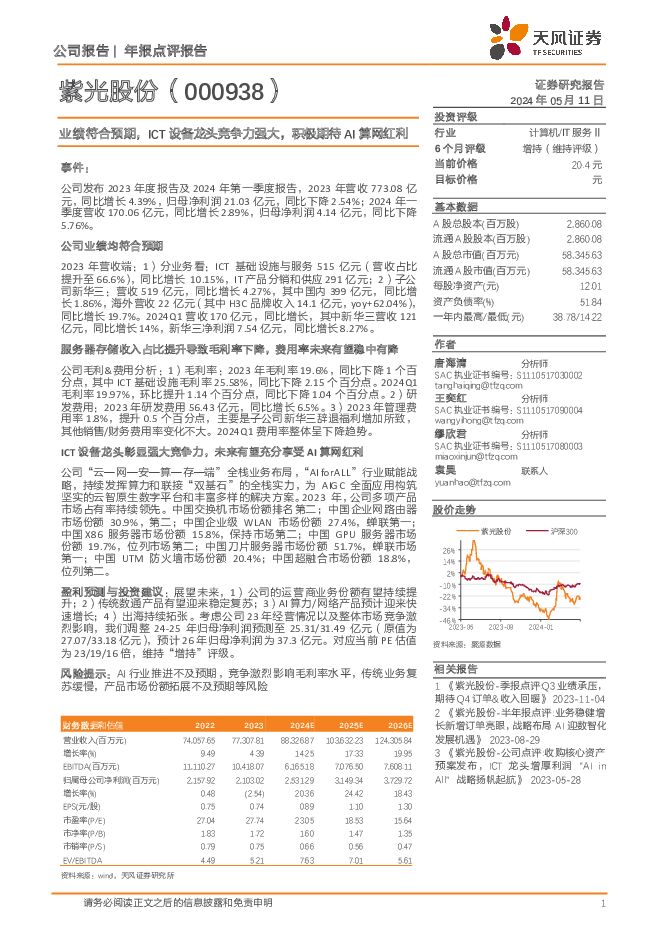

紫光股份 年报点评报告:业绩符合预期,ICT设备龙头竞争力强大,积极期待AI算网红利 天风证券 2024-05-12(3页) 附下载

紫光股份(000938)事件:公司发布2023年度报告及2024年第一季度报告,2023年营收773...

719.68 KB共3页中文简体

1天前73418积分