计算机行业研究:如何实现AGI:大模型现状及发展路径展望国金证券2024-04-05.pdf

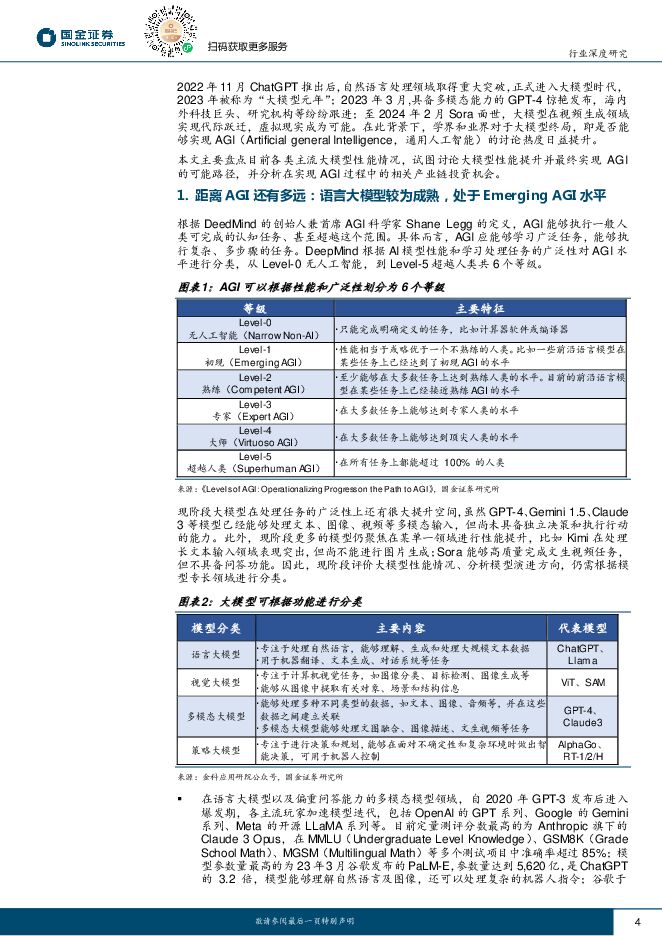

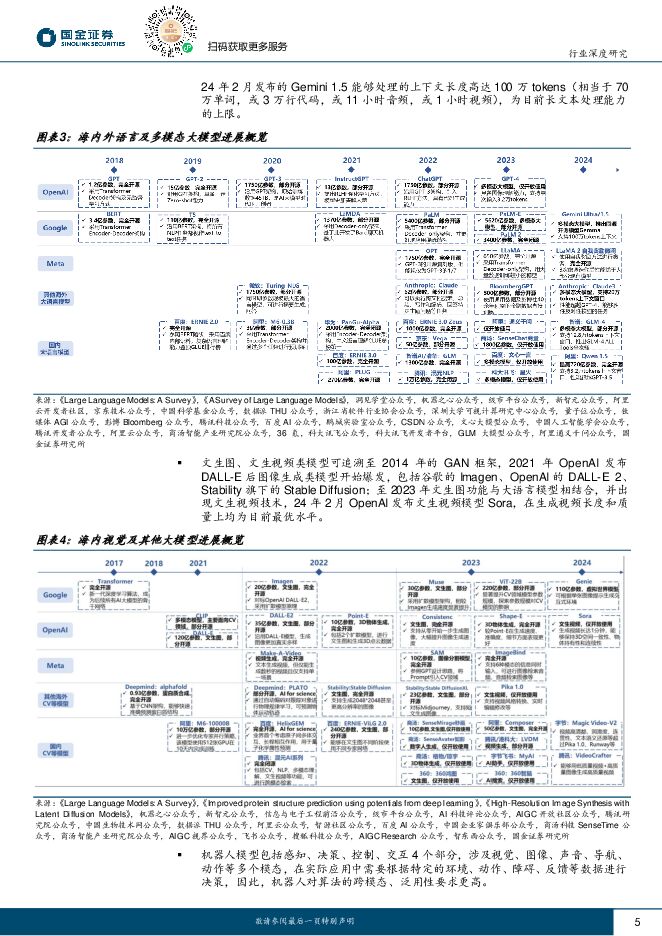

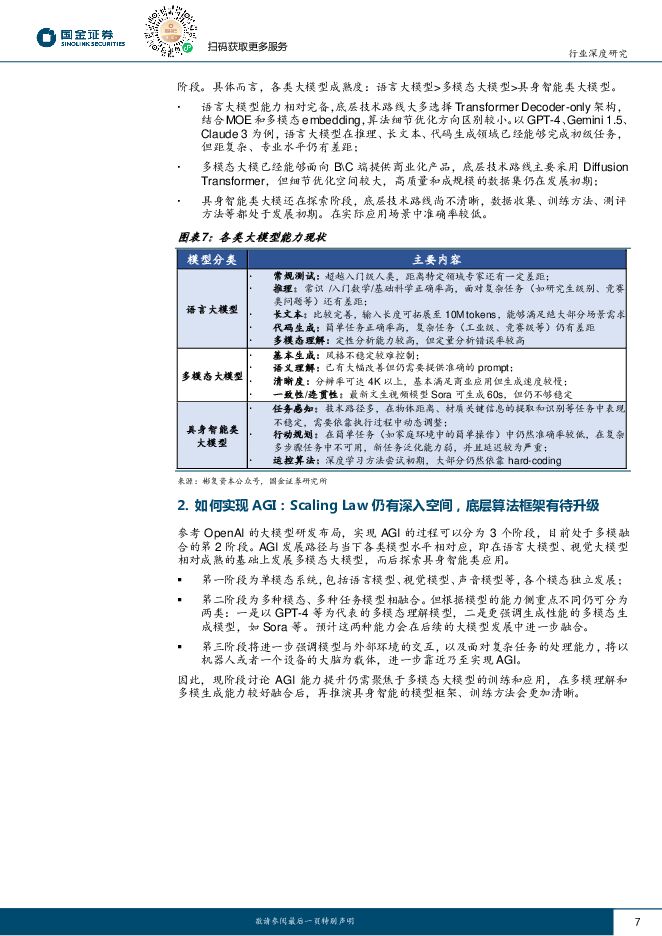

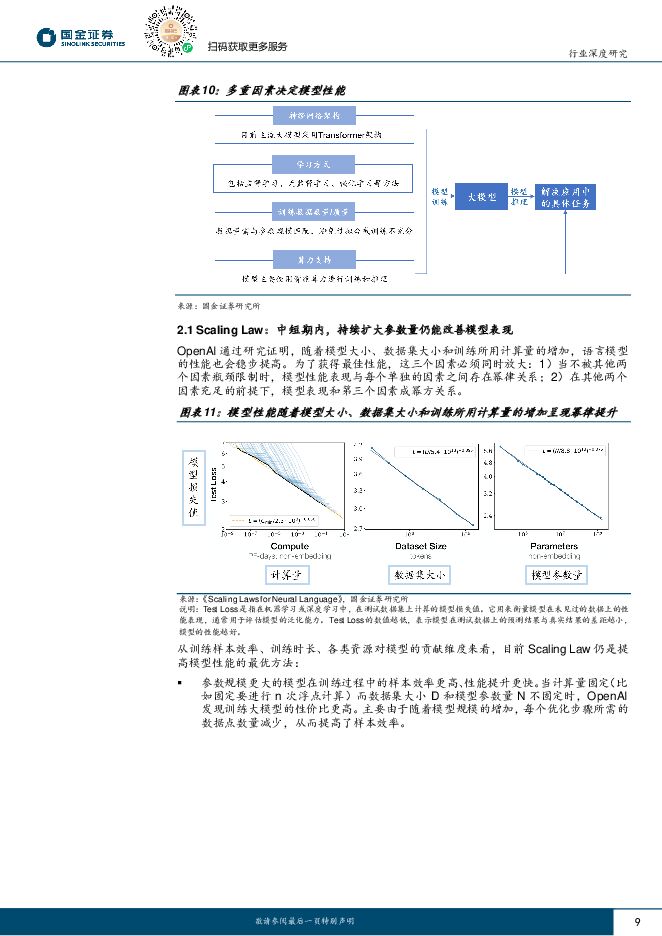

摘要:目前大模型能力仍处于Emerging AGI水平,就模型成熟度而言,语言大模型>多模态大模型>具身智能大模型。根据DeepMind的定义,AGI应能够广泛学习、执行复杂多步骤的任务。模型的AGI水平可分为Level-0至Level-5共6个等级,现阶段大模型在处理任务的广泛性上还有很大提升空间,即使是国际顶尖的大模型也仍处于Level-1Emerging AGI阶段。不同类型大模型成熟度差异较大,目前大语言模型能力相对完善,落地应用场景丰富,底层技术路线较为成熟;多模态大模型已经能够面向B\C端推出商业化产品,但细节优化空间较大;具身智能类大模型还在探索阶段,技术路线尚不清晰。现阶段讨论AGI能力提升仍需聚焦于多模态大模型的训练和应用。目前学界和业界重点关注Scaling Law的有效性,以及模型算法的可能改进方向。Scaling Law仍有深入空间。根据OpenAI研究,随模型参数量、数据集规模、训练使用的计算量增加,模型性能能够稳步提高,即Scaling Law。从训练样本效率、训练时长、各类资源对模型的贡献维度来看,目前ScalingLaw仍是提高模型性能的最优方法。OpenAI测算在模型参数量扩展到88万亿及之前,Scaling Law依旧有效,则中短期仍可延续此路线进行训练。模型骨干网络架构尚未演变至终局,微调及稀疏结构成为提升模型性能的重要方法。目前主流大模型均采用Transformer作为底层骨干网络,但针对编码器\解码器选择、多模态融合、自注意力机制等方面的探索仍在持续推进。微调使用更小的数据量、更短的训练时间,让模型能够适应下游任务,以降低边际落地成本。以MoE为代表的稀疏结构通过分割输入任务并匹配专家模型,能够提高模型的整体性能。开源模型性能优化速度快于闭源模型。我们认为,目前第一梯队AI大模型纷纷进军万亿参数,且不远的将来大模型将逐步逼近十万亿参数收敛值,对于本轮AI浪潮而言,找场景或优于做模型。在场景选择方面,对“幻觉”容忍度高且能够替代人工的场景可实现应用率先落地,如聊天机器人、文本/图像/视频创作等领域;而对“幻觉”容忍度较低的行业需要等待大模型能力提升或使用更多场景数据训练。投资建议算法、数据、算力是影响模型性能的关键因素,相关企业能够直接受益于大模型训练的持续推进,推荐国内AI算法龙头科大讯飞等,建议关注数据工程供应商以及算力产业链相关公司。对于行业类公司而言,寻找通过AI赋能带来效率提升的场景更为重要,建议关注AI+办公领域的金山办公、万兴科技,AI+安防领域的海康威视,AI+金融领域的同花顺等公司。风险提示底层大模型迭代发展不及预期;国际关系风险;应用落地不及预期;行业竞争加剧风险。

免责声明: 1.本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,不为其版权负责。 2.如发布机构认为违背了您的权益,请与我们联系,我们将对相关资料予以删除。 3.资源付费,仅为我们搜集整理和运营维护费用,感谢您的支持!

合集服务: 单个细分行业的合集获取请联系行研君:hanyanjun830

-

有色金属行业大宗及贵金属周报:再通胀预期+矿端扰动,铜价涨势延续 国金证券 2024-04-28(14页) 附下载

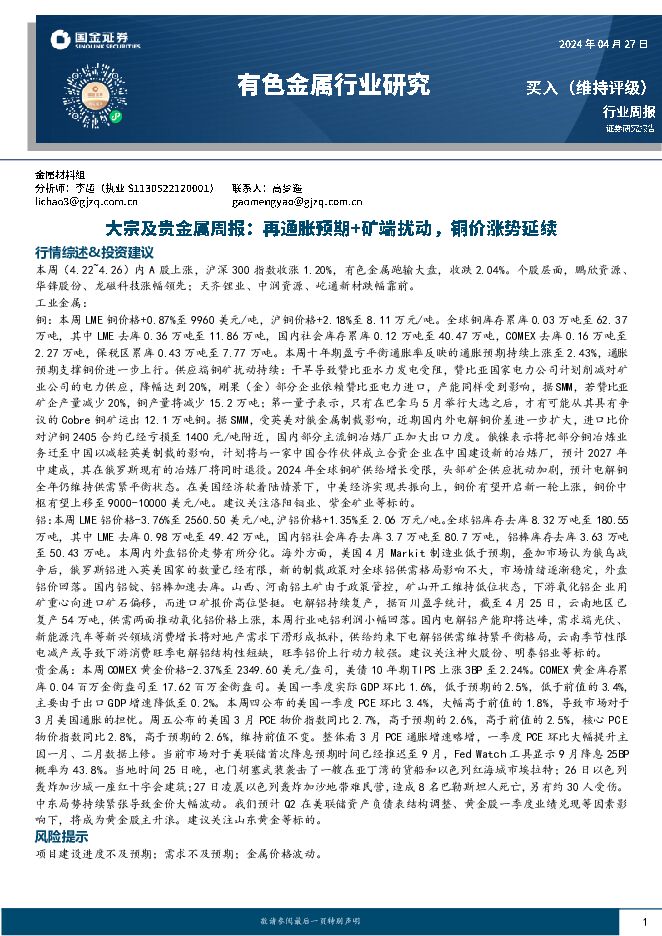

本周(4.22~4.26)内A股上涨,沪深300指数收涨1.20%,有色金属跑输大盘,收跌2.04%...

2.46 MB共14页中文简体

1天前020积分

-

稀土&小金属周报:供需矛盾加剧,看好锑价创历史新高 国金证券 2024-04-28(13页) 附下载

行情综述&投资建议本周(4.22-4.26)沪深300指数上涨1.51%,其中有色指数上涨0.43%...

1.49 MB共13页中文简体

1天前020积分

-

机械行业周报:看好机器人、工程机械及矿山机械 国金证券 2024-04-28(16页) 附下载

行情回顾本周板块表现:上周(2024/04/22-2024/04/26)5个交易日,SW机械设备指数...

1.86 MB共16页中文简体

1天前020积分

-

计算机周报:再次强调国内算力需求或是最确定主线 民生证券 2024-04-28(13页) 附下载

本周(4.22-4.26)本周沪深300指数上涨1.2%,中小板指数上涨1.82%,创业板指数上涨3...

1.11 MB共13页中文简体

1天前020积分

-

计算机行业周报:周观点:量子加密迎来布局机会 开源证券 2024-04-28(10页) 附下载

市场回顾:本周(4.22-4.26),沪深300指数上涨1.20%,计算机指数上涨6.31%。周观点...

1.01 MB共10页中文简体

1天前020积分

-

计算机行业2024Q1持仓分析:持仓比重回落,集中度提升 民生证券 2024-04-26(8页) 附下载

计算机持仓比重有所回落。通过对基金前十大重仓股进行估算,2024年Q1计算机板块(同花顺计算机指数成...

771.73 KB共8页中文简体

1天前220积分

-

计算机行业点评:密码产业或是量子产业最先落地应用 民生证券 2024-04-28(2页) 附下载

量子加密通信是利用量子态作为信息载体进行信息交互的通信技术,具备理论安全性。据国盾量子招股说明书,与...

575.88 KB共2页中文简体

1天前220积分

-

计算机行业点评:北京发布算力基础设施建设方案,加大智能算力投入并加快生态自主化进程 平安证券 2024-04-26(3页) 附下载

事项:4月25日,北京市经济和信息化局和北京市通信管理局联合发布《北京市算力基础设施建设实施方案(2...

500.42 KB共3页中文简体

1天前020积分

-

计算机行业点评:海外算力与国产算力共振 德邦证券 2024-04-28(2页) 附下载

投资要点:AI推动海外云巨头业绩超预期。近期,海外云巨头发布最新季报,充分展示AI投资对业绩的积极作...

282.95 KB共2页中文简体

1天前020积分

-

光伏支架行业研究:光伏支架市场空间广阔,跟踪支架渗透率有望提升 源达信息 2024-04-28(14页) 附下载

投资要点光伏支架为太阳能面板关键支撑部件光伏支架是太阳能光伏发电系统中用于支撑、安装和稳固太阳能面板...

2.16 MB共14页中文简体

1天前220积分

-

房地产行业研究:深圳启动以旧换新,LPR环比持平 国金证券 2024-04-28(20页) 附下载

行业点评本周A股地产、港股地产、物业板块均上涨。本周(4.20-4.26)申万A股房地产板块涨跌幅为...

2.32 MB共20页中文简体

1天前020积分

-

长久物流 利润同比大增,拓展新能源及数据业务 国金证券 2024-04-28(4页) 附下载

长久物流(603569)2024年4月26日,长久物流发布2023年年度。2023年公司实现营业收入...

1009.44 KB共4页中文简体

1天前218积分

-

云铝股份 复产逐步推进,旺季或迎量利齐升 国金证券 2024-04-26(4页) 附下载

云铝股份(000807)事件4月25日,公司发布24年一季报,1Q24实现营收113.58亿元,环比...

898.1 KB共4页中文简体

1天前018积分

-

迎驾贡酒 Q1业绩超预期,产品结构持续优化 国金证券 2024-04-26(4页) 附下载

迎驾贡酒(603198)2024年4月25日公司披露23年年报&24年一季报。23年实现营收67.2...

895.18 KB共4页中文简体

1天前218积分

-

洋河股份 分红比率持续提升,行稳致远 国金证券 2024-04-28(4页) 附下载

洋河股份(002304)业绩简评2024年4月26日公司披露23年年报及24年一季报。1)23年实现...

890.06 KB共4页中文简体

1天前018积分

-

英华特 涡旋压缩机龙头,国产替代稳步推进 国金证券 2024-04-28(4页) 附下载

英华特(301272)业绩简评4月26日,公司发布23年年报和24年一季报,23年公司实现收入5.5...

946.6 KB共4页中文简体

1天前218积分

-

玉禾田 订单表现出色,盼回款转好 国金证券 2024-04-26(4页) 附下载

玉禾田(300815)2024年4月25日晚间公司披露23年报及24年一季报。23全年实现营收61....

926.51 KB共4页中文简体

1天前018积分

-

新凤鸣 业绩持续复苏的长丝龙头! 国金证券 2024-04-26(8页) 附下载

新凤鸣(603225)业绩简评新凤鸣于2024年4月25日发布公司2024年第一季度报告,2024Q...

1.3 MB共8页中文简体

1天前218积分

-

万兴科技 标准化产品规模效应显现,利润率持续上升 国金证券 2024-04-28(6页) 附下载

万兴科技(300624)业绩简评收入&利润端-23年符合预期,24年Q1收入受基数、未做提价等因素影...

1.48 MB共6页中文简体

1天前018积分

-

同庆楼 Q1盈利受新店影响,全年规划积极 国金证券 2024-04-26(4页) 附下载

同庆楼(605108)事件24年4月25日公司披露23年报及24年一季报,23年实现营收24.01亿...

1.39 MB共4页中文简体

1天前018积分