AI系列报告之接口:AI大算力需求加速新技术渗透东方证券2023-04-19.pdf

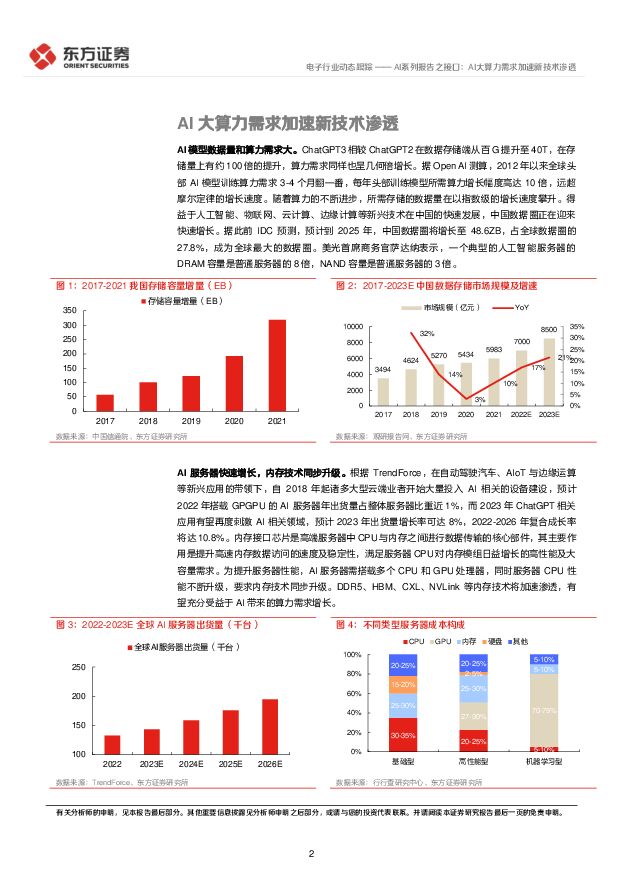

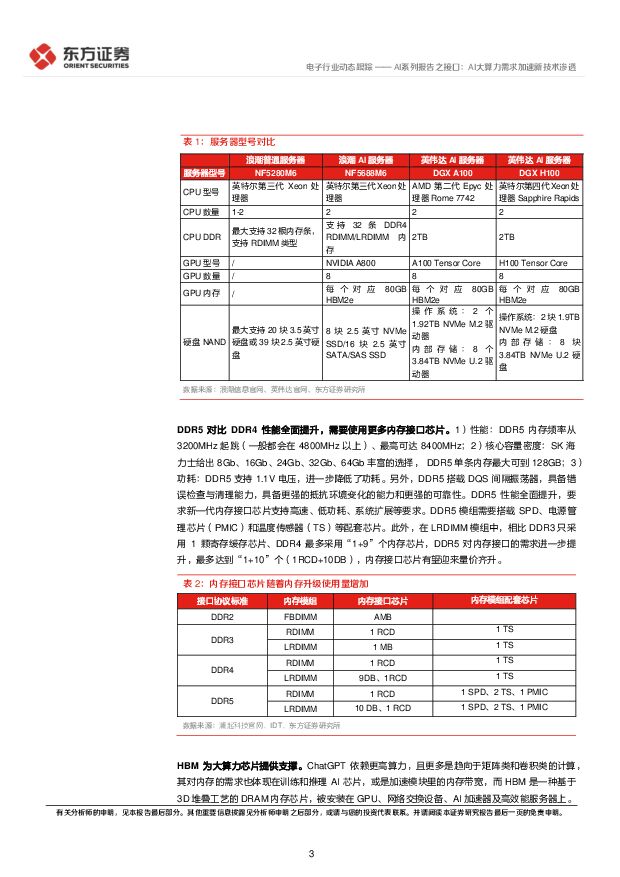

摘要:核心观点AI模型数据量和算力需求大。ChatGPT3相较ChatGPT2在数据存储端从百G提升至40T,在存储量上有约100倍的提升,算力需求同样也呈几何倍增长。据OpenAI测算,2012年以来全球头部AI模型训练算力需求3-4个月翻一番,每年头部训练模型所需算力增长幅度高达10倍,远超摩尔定律的增长速度。美光表示,一个典型的人工智能服务器的DRAM容量是普通服务器的8倍,NAND容量是普通服务器的3倍。AI服务器快速增长,内存技术同步升级。根据TrendForce,预计2022年搭载GPGPU的AI服务器年出货量占整体服务器比重近1%,而2023年ChatGPT相关应用有望再度刺激AI相关领域,预计2023年出货量增长率可达8%,2022-2026年复合成长率将达10.8%。为提升服务器性能,AI服务器需搭载多个CPU处理器,同时服务器CPU性能不断升级,要求内存技术同步升级。DDR5、HBM、CXL、NVLink等内存技术将加速渗透,有望充分受益于AI带来的算力需求增长。DDR5需要使用更多内存接口芯片。DDR5的内存接口缓存芯片RCD价格远高于DDR4,内存接口芯片有望迎来量价齐升。DDR5芯片需要搭载更多的SPD、电源管理芯片(PMIC)和温度传感器(TS)等配套芯片。HBM为大算力芯片提供支撑。如今搭载于新兴AI应用的内存芯片亟待升级,而HBM是一种基于3D堆叠工艺的DRAM内存芯片,被安装在GPU、网络交换设备、AI加速器及高效能服务器上。HBM作为一种带宽远超DDR/GDDR的高速内存,将为大算力芯片提供能力支撑,同时生成类模型也会加速HBM内存进一步增大容量和增大带宽。TrendForce预估2023-2025年HBM市场年复合成长率有望成长至40-45%以上。CXL兼容性强、可实现内存一致性。CXL为英特尔于2019年推出的一种开放性互联协议,能够让CPU与GPU、FPGA或其他加速器之间实现高速高效的互联,从而满足高性能异构计算的要求。在AMD、ARM、IBM以及英特尔等主要CPU供应商的支持下,CXL已经成为领先的行业标准。美光科技在22年5月与投资者交流时曾预测CXL相关产品的市场规模,到2025年预计将达到20亿美金,到2030年可能超过200亿美金。NVLink可最大化提升系统吞吐量。第四代NVIDIA®NVLink®技术可为多GPU系统配置提供高于以往1.5倍的带宽,以及增强的可扩展性。单个NVIDIA H100 TensorCoreGPU支持多达18个NVLink连接,总带宽为900GB/s,是PCIe5.0带宽的7倍。第三代NVIDIA NV Switch™基于NVLink的高级通信能力构建,可为计算密集型工作负载提供更高带宽和更低延迟。NVIDIA DGX™H100等服务器可利用NVLink技术来提高可扩展性,进而实现超快速的深度学习训练。投资建议与投资标的我们看好服务器带来的接口芯片技术升级趋势,建议关注澜起科技、聚辰股份、裕太微、龙迅股份。风险提示服务器需求拉动不及预期、新技术渗透率不及预期。

免责声明: 1.本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,不为其版权负责。 2.如发布机构认为违背了您的权益,请与我们联系,我们将对相关资料予以删除。 3.资源付费,仅为我们搜集整理和运营维护费用,感谢您的支持!

合集服务: 单个细分行业的合集获取请联系行研君:hanyanjun830

-

游戏Ⅱ行业深度报告:游戏行业2023年及2024Q1业绩综述:产品周期驱动业绩增长,全方位拥抱AI技术变革 东吴证券 2024-05-07(18页) 附下载

投资要点行业概况:版号重启高质量发放,行业景气度回暖。2022年4月游戏版号重启发放,此后步入常态化...

1.24 MB共18页中文简体

2天前58920积分

-

传媒互联网行业2024年中期投资策略:AI应用落地生根,内容复兴行而不辍 开源证券 2024-05-07(59页) 附下载

1、传媒板块2024年上半年整体震荡,涨幅靠后,估值回落传媒板块自2023年10月以来市场表现整体震...

4.34 MB共59页中文简体

2天前64920积分

-

电子行业2024年中期投资策略:半导体景气度持续回暖,重视消费电子、AI、自主可控 开源证券 2024-05-07(55页) 附下载

核心观点1.观点:随着下游需求逐渐复苏,2024年电子板块受益于低基数效应,同比增长显著,重点关注消...

2.74 MB共55页中文简体

2天前62220积分

-

【AI金融新纪元】系列报告(三):赋能金融,AI开启新时代 东吴证券 2024-05-07(32页) 附下载

核心要点:金融科技发展加速,大模型落地开启数字金融新时代回顾与展望“科技+金融”三个时代:1)金融信...

1.89 MB共32页中文简体

2天前18920积分

-

传媒行业周报:5月AI板块海外持续高关注,24Q1季报传媒公司业绩表现分化,建议关注个股 海通国际 2024-05-07(10页) 附下载

周报观点,我们认为:AI应用:全年主线持续重点看好。1)5月仍处于海外重点相关产业链公司(如英伟达)...

1.7 MB共10页中文简体

2天前56620积分

-

电子行业周观点:AI存储需求高景气,晶圆大厂切入先进封装赛道 万联证券 2024-05-07(12页) 附下载

行业核心观点:2024年4月29日至5月5日期间,沪深300指数上涨0.56%,申万电子指数上涨1....

1.35 MB共12页中文简体

2天前40420积分

-

计算机行业点评:北美云厂商24年资本支出指引维持乐观,AI算力建设持续加速 财信证券 2024-05-07(3页) 附下载

投资要点:北美四大云厂商陆续发布24Q1的财报,合计资本支出同比大幅增加,对于24年全年的资本支出指...

326.64 KB共3页中文简体

2天前48020积分

-

电子行业周报:进迭时空发布AI CPU芯片,SK海力士称HBM售罄 甬兴证券 2024-05-07(14页) 附下载

核心观点本周核心观点与重点要闻回顾算力芯片:进迭时空发布全球首颗8核RISC-V AI CPU芯片K...

875.19 KB共14页中文简体

2天前96220积分

-

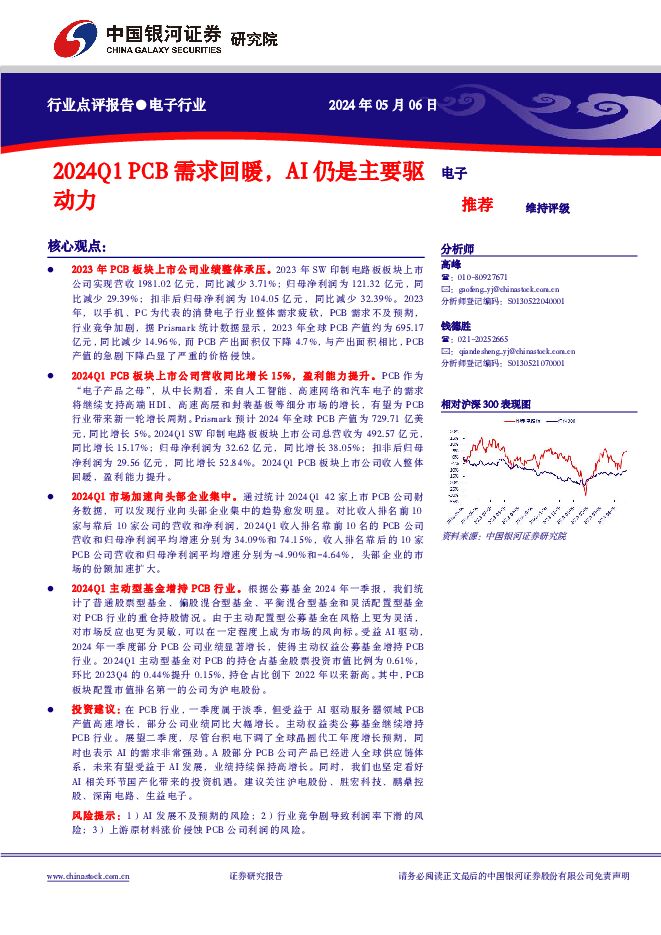

电子行业:2024Q1 PCB需求回暖,AI仍是主要驱动力 中国银河 2024-05-07(8页) 附下载

核心观点:2023年PCB板块上市公司业绩整体承压。2023年SW印制电路板板块上市公司实现营收19...

551.52 KB共8页中文简体

2天前55220积分

-

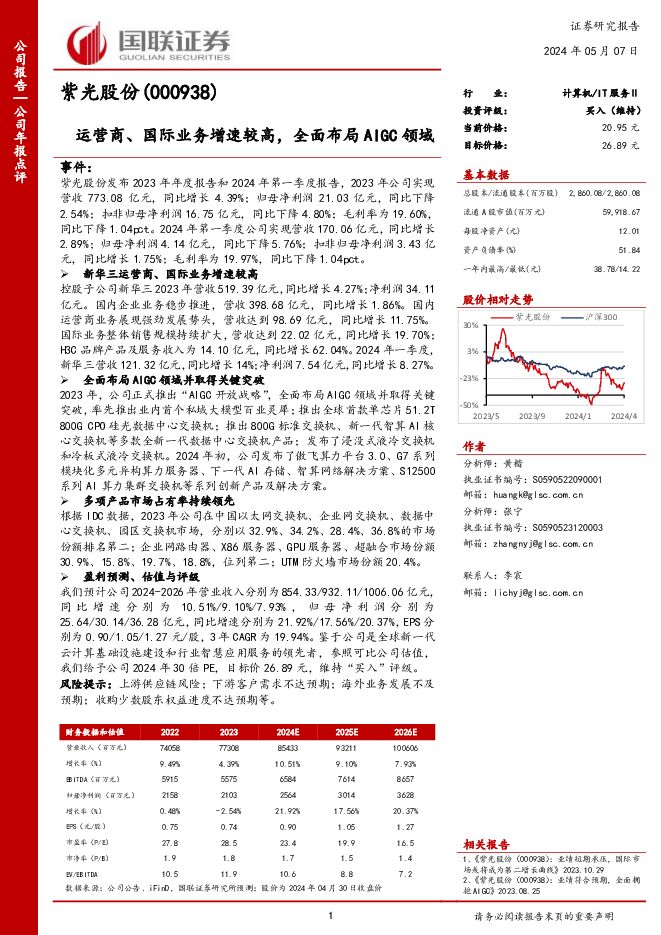

紫光股份 运营商、国际业务增速较高,全面布局AIGC领域 国联证券 2024-05-07(3页) 附下载

紫光股份(000938)事件:紫光股份发布2023年年度报告和2024年第一季度报告,2023年公司...

387.56 KB共3页中文简体

2天前40518积分

-

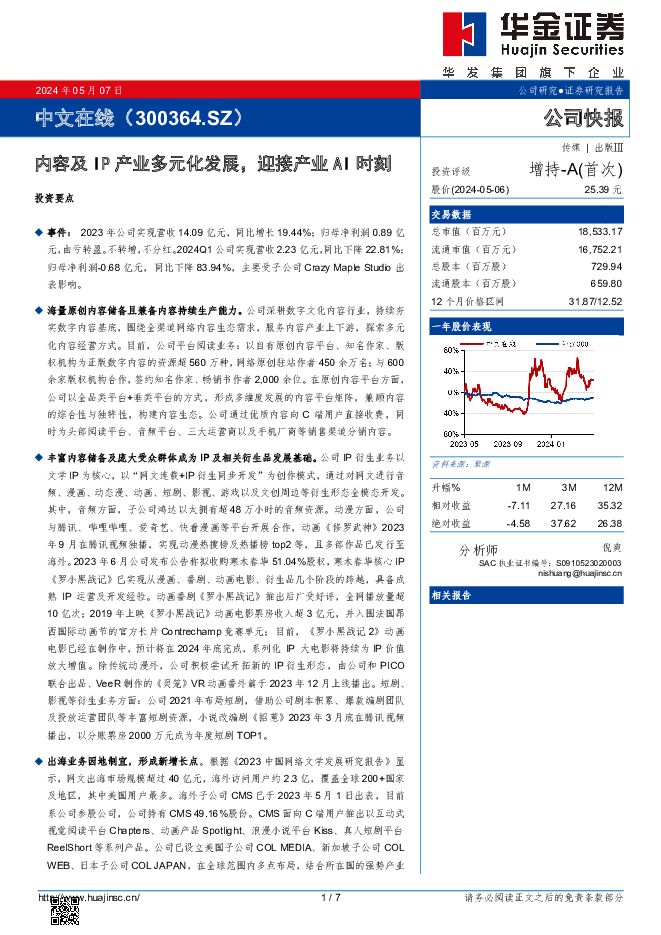

中文在线 内容及IP产业多元化发展,迎接产业AI时刻 华金证券 2024-05-07(7页) 附下载

中文在线(300364)投资要点事件:2023年公司实现营收14.09亿元,同比增长19.44%;归...

352.62 KB共7页中文简体

2天前7318积分

-

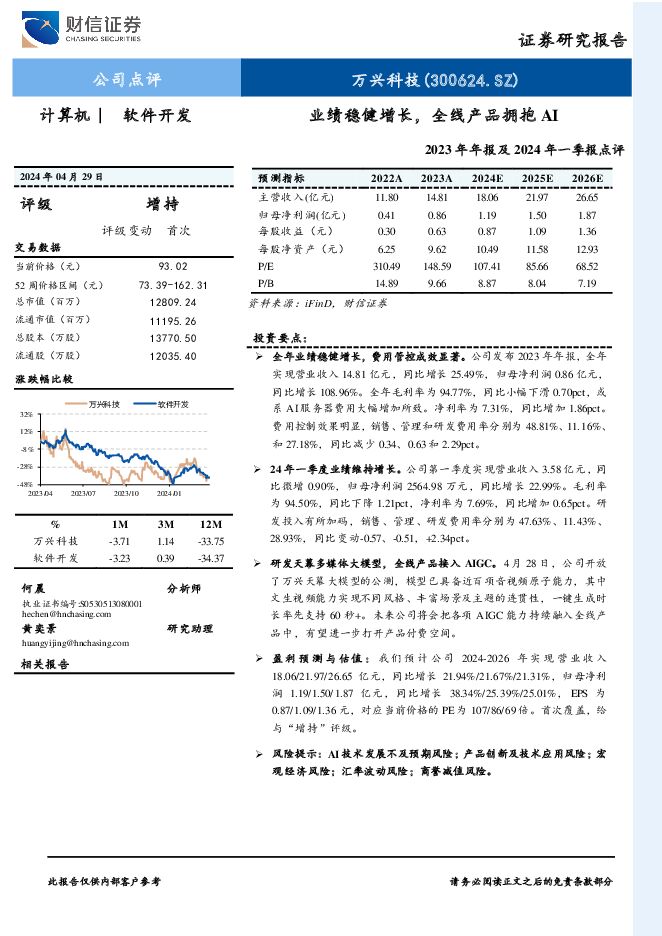

万兴科技 2023年年报及2024年一季报点评:业绩稳健增长,全线产品拥抱AI 财信证券 2024-05-07(3页) 附下载

万兴科技(300624)投资要点:全年业绩稳健增长,费用管控成效显著。公司发布2023年年报,全年实...

761.33 KB共3页中文简体

2天前55118积分

-

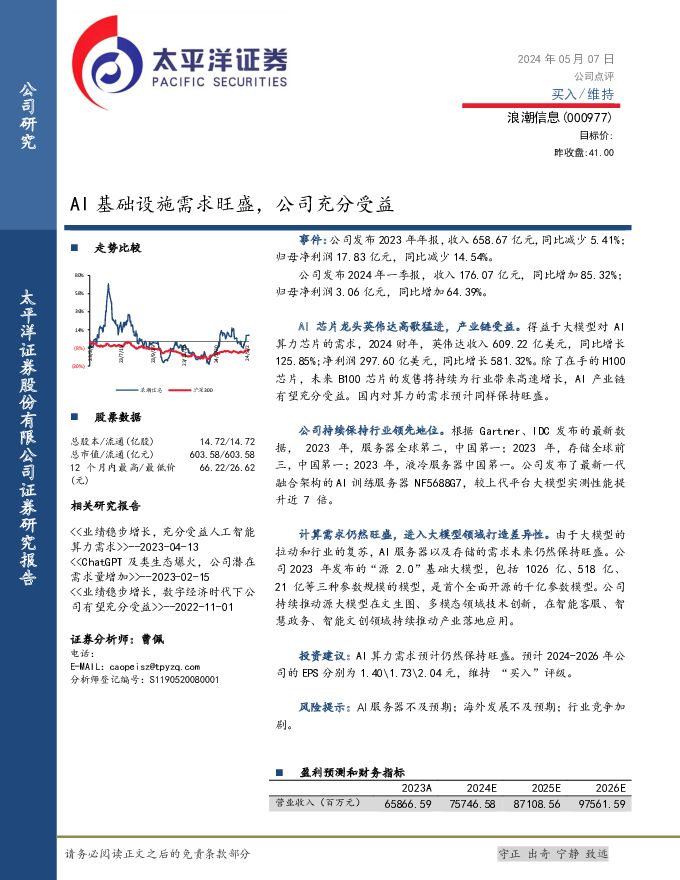

浪潮信息 AI基础设施需求旺盛,公司充分受益 太平洋 2024-05-07(6页) 附下载

浪潮信息(000977)事件:公司发布2023年年报,收入658.67亿元,同比减少5.41%;归母...

752.34 KB共6页中文简体

2天前85418积分

-

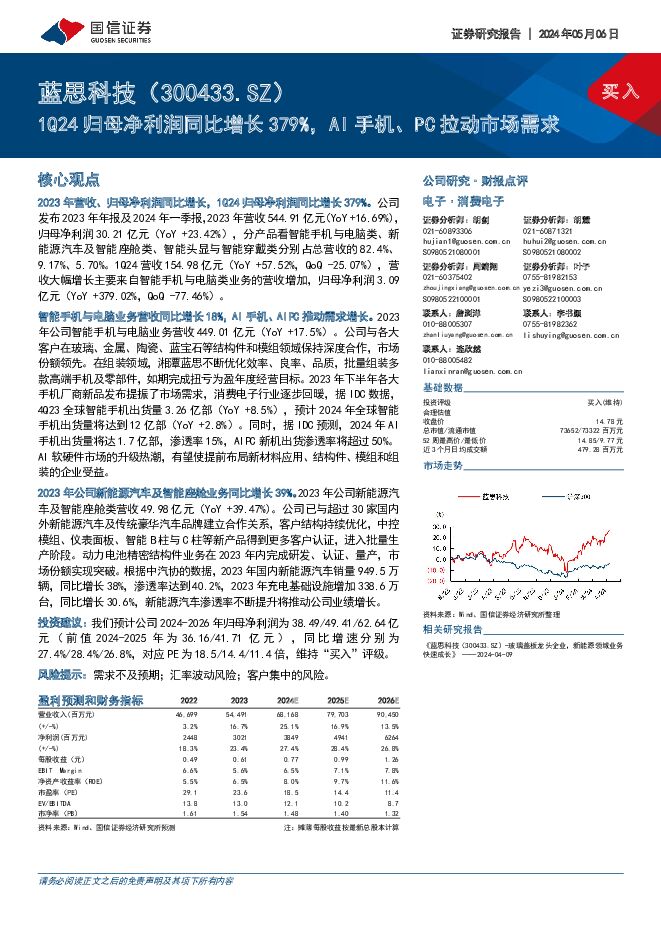

蓝思科技 1Q24归母净利润同比增长379%,AI手机、PC拉动市场需求 国信证券 2024-05-07(5页) 附下载

蓝思科技(300433)核心观点2023年营收、归母净利润同比增长,1Q24归母净利润同比增长379...

586.09 KB共5页中文简体

2天前19018积分

-

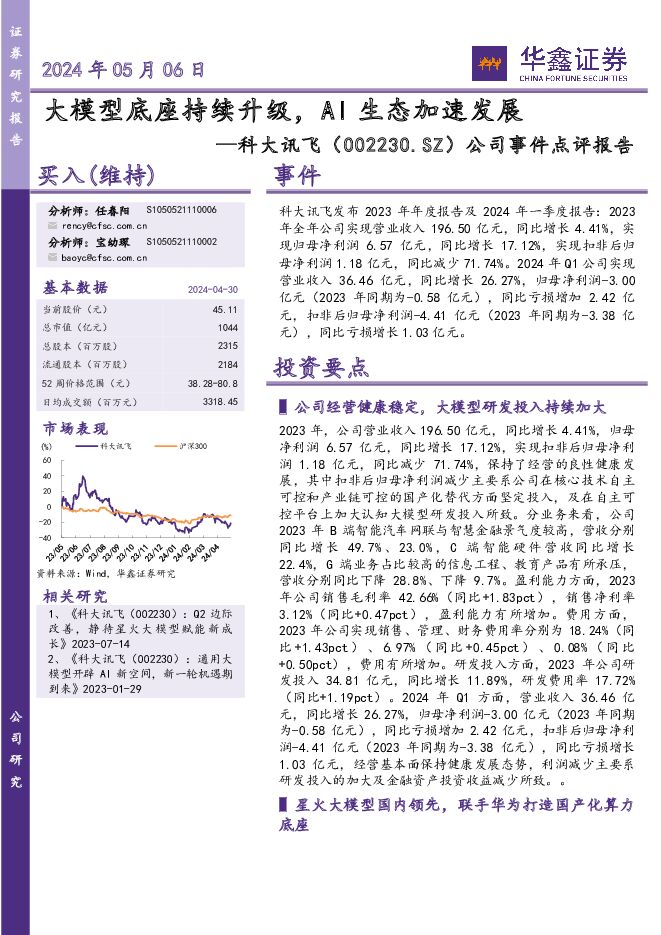

科大讯飞 公司事件点评报告:大模型底座持续升级,AI生态加速发展 华鑫证券 2024-05-07(6页) 附下载

科大讯飞(002230)事件科大讯飞发布2023年年度报告及2024年一季度报告:2023年全年公司...

346.37 KB共6页中文简体

2天前67118积分

-

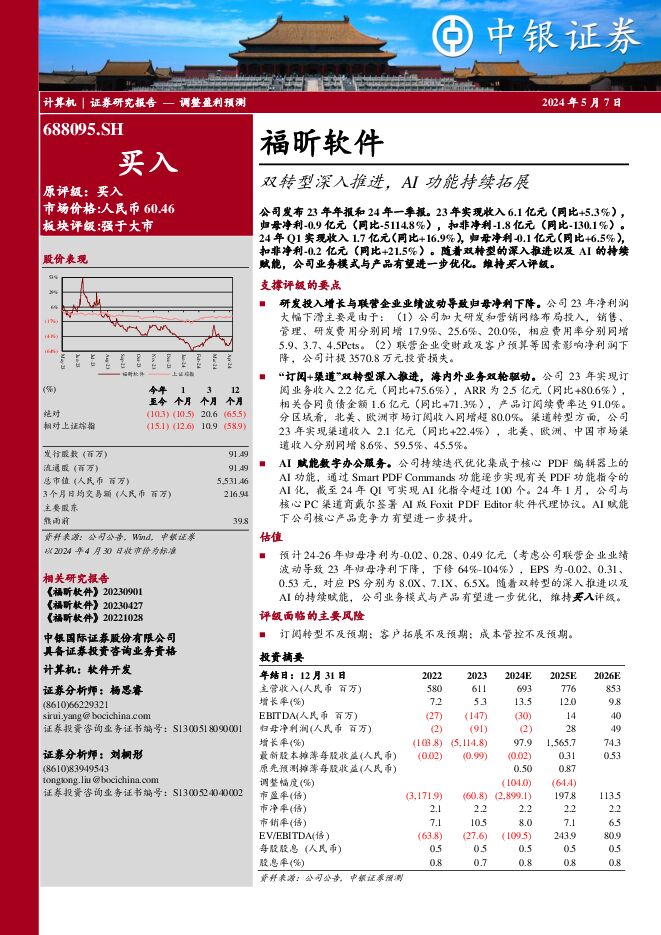

福昕软件 双转型深入推进,AI功能持续拓展 中银证券 2024-05-07(4页) 附下载

福昕软件(688095)公司发布23年年报和24年一季报。23年实现收入6.1亿元(同比+5.3%)...

636.19 KB共4页中文简体

2天前88418积分

-

传媒行业周报:关注海内外AI视频、AI搜索新进展及游戏新品 开源证券 2024-05-06(18页) 附下载

首支Sora生成的MV诞生,ChatGPT搜索引擎或发布,继续布局AI应用据新智元报道,五一期间,O...

3.05 MB共18页中文简体

3天前37220积分

-

传媒互联网产业行业研究:基本面尚在筑底,静待业绩回升及AI落地 国金证券 2024-05-06(23页) 附下载

投资逻辑传媒板块:收入持续修复,4Q23及1Q24盈利水平短期承压;估值催化弱化,市场表现走弱。1)...

2.67 MB共23页中文简体

3天前61420积分

-

计算机行业周报:海外科技巨头加码AI上调CAPEX,持续看好算力产业链价值 国投证券 2024-05-06(13页) 附下载

海外科技巨头业绩亮眼,加码AI上调CAPEX近日,海外科技巨头Microsoft、Google、Me...

1.2 MB共13页中文简体

3天前92820积分

-

通信行业2024年中期投资策略:新质生产力时代的“AI算力+国产替代+卫星”革命 开源证券 2024-05-06(59页) 附下载

核心观点1、回顾与展望:板块估值仍处于较低水平,聚焦“AI算力+国产替代+卫星”三条核心赛道截至20...

4.88 MB共59页中文简体

3天前41420积分